Google abre nuevos canales de comunicación para las personas con discapacidad

Leer en otros idiomas:

El reconocimiento del habla ha evolucionado rápidamente en los últimos años. Sin embargo, comunicarse sigue siendo difícil para las personas con deficiencias del habla. Google quiere cambiar esto con el Proyecto Euphonia.

¿Quiénes de vosotros ya utiliza asistentes de idiomas como el Asistente de Google? No importa si constantemente o sólo de vez en cuando, pero seguro que os ha molestado más de una vez el simple hecho de que no os entendiera al hablar. Y a grandes rasgos diría que la mayoría de vosotros no tiene problemas de lenguaje.

Pero, ¿qué pasa con las personas que no pueden comunicarse como muchas otras debido a un derrame cerebral, esclerosis múltiple, ELA, la enfermedad de Parkinson o cualquier otro trastorno neurológico o motor? Después de todo, la comunicación, especialmente la comunicación verbal, es una parte importante de nuestras vidas. Para abordar este problema desde el punto de vista técnico, Google ha creado el Proyecto Euphonia como parte del equipo de Social AI.

Proyecto Euphonia

El objetivo del Proyecto Euphonia es utilizar la Inteligencia Artificial para mejorar el reconocimiento del habla y el reconocimiento de expresiones faciales y gestos. Por ejemplo, se han asociado con el ALS Therapy Development Institute (ALS TDI) y la ALS Residence Initiative (ALSRI) para grabar numerosas imágenes de personas con esclerosis y utilizarlas como base para mejorar el reconocimiento del habla.

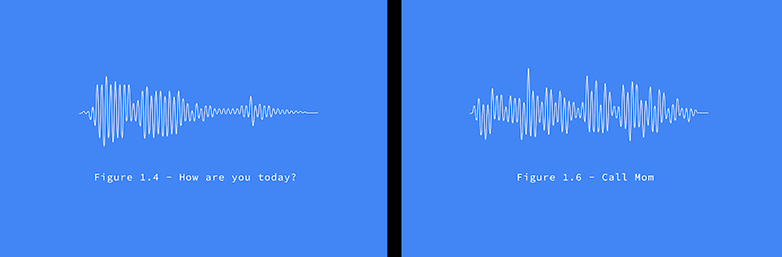

Durante el reconocimiento, el software de Google convierte las muestras de voz grabadas en un espectrograma o una representación visual de los sonidos. Todo se convierte entonces en el espectrograma habitual para "entrenar" el sistema, que se supone que reconoce mejor este tipo de habla menos común.

En el siguiente vídeo se puede ver a Dimitri Kanevsky, un lingüista que aprendió inglés después de quedar sordo de niño en Rusia. Ya utiliza un programa de traducción en vivo que fue entrenado con la ayuda del Proyecto Euphonia y que ahora le ayuda a comunicarse.

Como se puede ver, también es importante ser capaz de reconocer expresiones faciales, gestos e incluso sonidos como zumbidos o chasquidos con la lengua para, por ejemplo, seguir proporcionando una oportunidad de comunicación en personas con esclerosis múltiple avanzada. Steve Saling, que sufre de ELA, por ejemplo, utiliza la detección de ruido para controlar varios dispositivos inteligentes para el hogar.

Fuente: Google

Con esta opción se abrirán las puertas para que estas personas con discapacidades, puedan tener un smartphone de gama alta con un extra particular, la facilidad de comunicarse de una forma efectiva.

¡Muy buenas noticias! Particularmente a mí es lo que me ha parecido más útil de la conferencia de Google. Un gran avance, sin duda. ¡Gracias por leernos!